2019-10-29일 NAVER에서 주최하는 국내 최대 규모의 개발 컨퍼런스 deview2019가 주최되었다. 참석 경쟁률이 어마어마했는데 필자는 네이버 시계로 참여 시간과 동시에 등록을 했지만 이미 정원이 초과된 이후였다. 이번 deview는 참석을 못하는구나 하고 있었는데 주변 지인이 자기 참여 티켓을 양도해주어 감사하게 참여하게 되었다.

4차 산업혁명이라는 단어가 2016년 세계 경제 포럼에 처음 주창된 이례로 연일 IT에 대한 붐이 끊이지 않고있다. 특히 우리나라는 IT 강국으로써 이 IT에 관한 R&D나 투자를 아끼지 않는 모습을 모였는데 오늘 deview에서 이러한 모습이 더 잘 드러나지 않았나 싶다.

DAY1은 대부분 R&D의 관점에서 바라보는 AI에 관련된 세션들이 많았다. 많은 세션들이 있었지만, 동시에 4개의 세션을 다른 강연장에서 진행했고, 참가 티켓(팔찌)이 있어야만 입장이 가능했다. 꼭 세션을 듣지 않더라도, 강연장 앞에 많은 부스들이 마련되어 있어, 이것저것 참여할 수 있는 것들이 많았다.

모든 세션에 참여하고 싶었지만, 선택을 해야했기 때문에 평소 내가 관심 있던 분야의 세션을 골라서 참석하게 되었다. 그중 기억에 남는 두 가지에 대해서 간략히 포스팅을 해볼까 한다.

Deep Learning for Human Sensing for Visual Data

나는 크게 NLP 세션과 Computer Vision 세션에 관심을 가지고 참여했다. 그중 첫번째로 소개하고 싶은 세션은 "Deap Learning for Human Sensing for Visual Data"이라는 세션으로 NAVER LABS EUROPE에 소속되어 계신 Gregory ROGEZ님의 세션이었다. Deep Learning을 이용한 사람의 모션을 인식하는 것에 관한 세션이었는데 솔직히 말하자면 강의자 님의 발음이 영국식 영어였고, 더군다나 기술 용어가 대부분이었기 때문에 많은 부분 이해하진 못했다. 다만 흥미로웠던 점은 이러한 이러한 정교한 인식 기술에 관한 데이터의 양이었다. 지난해 openCV와 tensorflow를 활용해 사람의 얼굴 표정을 인식하는 프로젝트를 진행한 적이 있었다. 대부분의 코드는 오픈소스를 사용했지만 tensorflow와 classification 알고리즘을 이용해서 모델을 학습시키고, 인식률을 올리려고 노력한 경험이 있다. 하지만 한 가지 아이러니했었던 사실은 그 당시 내가 학습시킨 데이터는 약 4천 장에 가까운 사진이었음에도 불구하고, 인식률이 단 1%도 상승하지 않는다는 점이었다. 서양인의 사진이어서 그런가 싶어 동양인의 데이터도 약 700장 함께 학습시켰지만, 결과는 같았다.

Data Science. Machin Learning, Big Data 등등 4차 산업혁명의 선두에 선 많은 키워드들을 아우르는 단어이다. 그만큼 인공지능은 데이터와 밀접한 관련이 있다. 이 포스팅에서 인공지능의 모든 개념에 관하여 이야기할 순 없지만 인공지능이란 쉽게 말해 주어진 데이터를 학습하고, 그 데이터들 사이에 패턴을 발견하여 그 패턴에 맞게 다양한 상황에 대처하는 기술이다. 그렇기에 데이터의 양은 모델의 성능에 직접적인 영향을 끼친다. 그치만 내가 간과했었던 부분을 오늘 세션을 통해 알게 되었는데, 그것은 바로 Data quality. 다시 말해 데이터의 질이다.

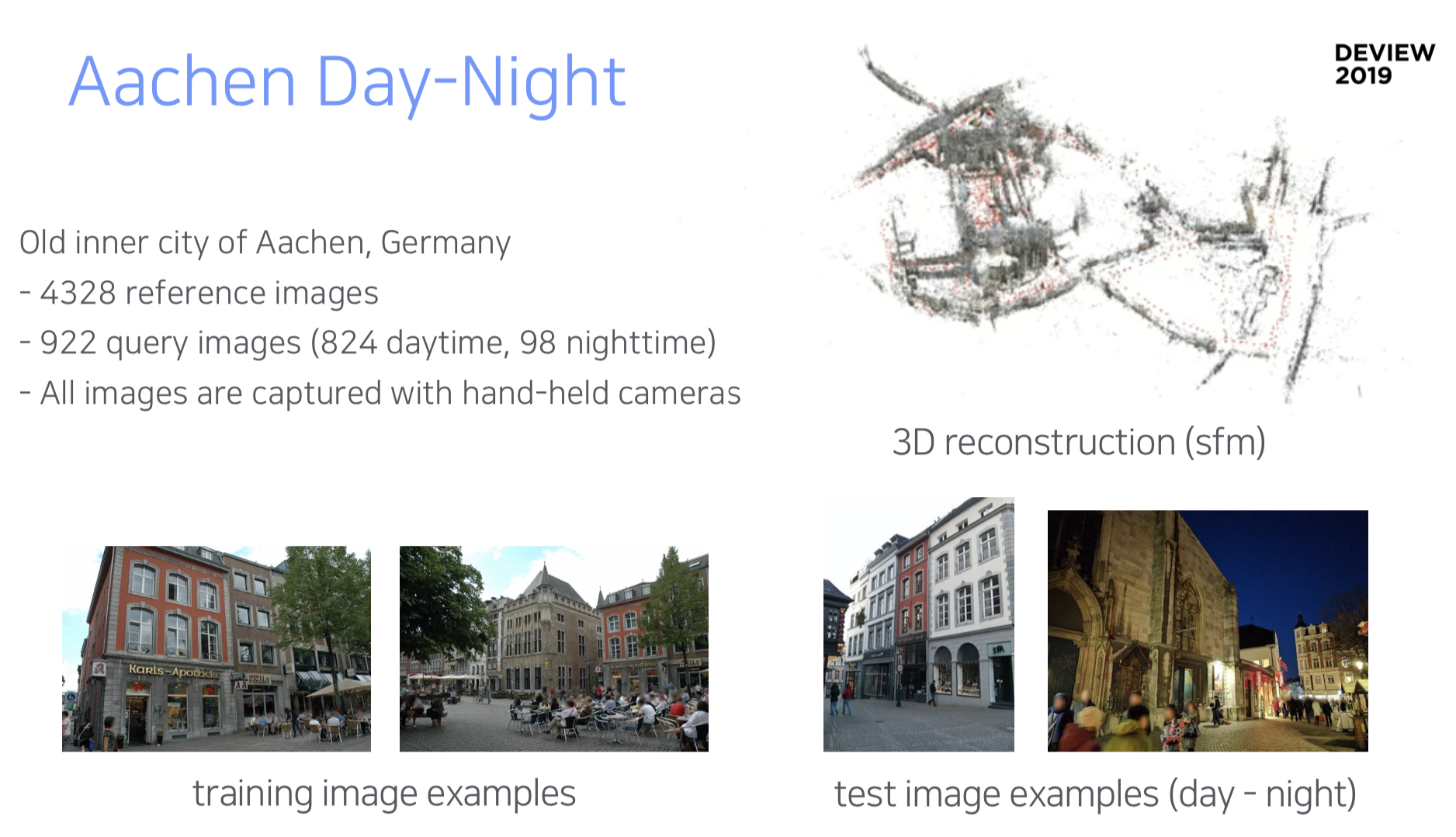

※ 위의 이미지들은 "Deap Learning for Human Sensing for Visual Data 세션의 자료는 아니고, 이 후에 있는 Dr. Martin Humenberger님의 "When Deep Learning meets Visual Localization"세션의 자료이다.본질적으로 Computer Vision 기술이기 때문에 해당 자료로 포스팅을 이어가겠다.

위의 이미지들은 NAVER LABS mapping robot M1이 학습한 데이터들의 나열이다. 사진 속의 각각의 장소들은 서로 다른 특성을 가지고 있다. 예를 들면 첫 번째 사진은 굉장히 구조적인 캠퍼스, 세 번째 사진은 밤과 낮의 데이터, 다섯 번째 사진은 상가가 많은 지하, 마지막 여섯 번째 사진은 실내에 조명이 있는 환경 (밝은 전시관, 어두운 전시관 등) 또한 강연자 님은 이러한 데이터들을 소개하며 "각각의 장소들은 이러이러한 특색을 잘 나타내고 있다."라고 말씀하셨다. 또한 이후의 NLP 세션에서 알게 된 사실이지만, 데이터가 무조건 많다고 좋은 것이 아니고 가장 적당한 효율을 내는 데이터의 량을 모델에 학습시킨다고 한다.

Dialog-BERT: 100억 건의 메신저 대화로 일상대화 인공지능 서비스하기

다음은 스캐터랩의 이주홍님의 세션이었다. 최근 NLP 모델을 활용한 프로젝트를 진행하고 있었기 때문에 더욱 기대되는 세션 중 하나였다. 흔히 한국어는 배우기 힘든 언어라고들 많이 이야기한다. 왜냐하면 그만큼 동의어가 많고 축약되거나 어휘의 변형이 자유롭기 때문이다. 그렇다면 컴퓨터 입장에서 한국어는 어떨까? 아마 많은 부분 어려움이 있을 것이다.

이 세션에서 나온 서비스는 업무를 하는 챗봇이 아니라 사람과 대화하고 위로하고 공감하는 것이 목적인 챗봇이었다. "이게 무슨 차이지? 같은 대화가 아닌가?"라고 생각하기 쉽지만 앞서 이야기했듯 역시나 데이터의 차이이다.

위키피디아의 텍스트에 비해 일상적으로 우리가 사용하는 카카오톡과 같은 텍스트는 대체로 문장이 짧고, 변형이 많으며 생략된 부분이 많다. 예를들어 "떡볶이?"라는 부분은 "먹을래?"라는 부분이 생략되어있고, "옼ㅋㅋ"와 같은 부분은 채팅을 치며 난 오타이지만 사람은 알아들을 수 있는 영역 안에 있기 때문에 우리는 크게 이질감을 느끼지 못한다. 하지만 컴퓨터는 다르다. 컴퓨터 입장에서 위키피디아의 텍스트와 카카오톡의 텍스트는 전혀 다른 언어의 것과 마찬가지이다. 그 예로 위키피디아와 같은 문체의 데이터로 학습한 모델은 대화체의 텍스트를 전혀알아 듣지 못하고, 또 역시 대화체로 학습된 모델은 위키피디아와 같은 문체의 텍스트를 전혀 알아듣지 못한다.

그 외에도 인식률을 높이기 위해 다양한 시도를 하였는데, 각 단어 사이에 turn을 두어서 (special SEPT)를 두어 구분을 두는 방법과, 우리가 하는 말 중에 대부분이 Reaction에 가깝다는 점을 이용해 (빈도수가 높은 상위 0.01%의 문장이 전체 사용 문장의 20%를 차지한다고 한다.) 대화의 많은 부분을 커버하였다고 한다.

모델의 학습 데이터는 카카오톡의 100억개의 데이터와 라인의 2억 개의 데이터를 사용했고, 학습에는 총 30일의 시간이 소요되었다고 한다. 오랜 기간이라 놀랄 수 있지만, TPU기준으로 1~2일만으로도 꽤 높은 성능이 나왔고 그 이후의 기간 동안은 2~3% 정도의 차이를 보였다고 한다.

그런데 막상 모델의 학습이 끝나고나니 문제는 의외로 다른 곳에서 발생했는데 바로 서비스의 속도였다. 아무리 인식률이 뛰어나더라도 대답에 오랜 시간이 걸리면 이질감을 느끼게 된다. 때문에 모델 경량화를 하게 되었는데, 이때 사용한 방법이 knowledge distillation이라고 한다.

disttillation이란 쉽게말해 학습 모델에 선생님 모델을 두는 것이다. 예를 들어 고양이 사진이 있다고 해보자. 이러한 고양이 사진을 모델이 받게 되면 선생님 모델은 "이 사진은 고양이야!"와 같은 응답이 아니라 "고양이랑도 비슷하고~ 사자랑도 비슷하고~"와 같은 대략적인 그림을 그려서 학생 모델에게 보내준다. 그리고 학생 모델은 이러한 데이터를 바탕으로 응답하게 되는 식의 방식이다. 실제로 이러한 방법으로 약 2.7배의 성능 향상을 보였다고 하니 정말 신기했다.

여기서 끝이 아니었다. 이번엔 multi-task를 구현해서 선생님 모델을 여러 개를 두는 것에 도전하였다고 한다. (경이로움...)

에디슨의 전구가 먼저 발명되고 난 후에 전기가 무엇인지 알게된 것처럼 AI 역시 그러하다. 아직 우리는 AI가 무엇인지 잘 모르지만 그것을 사용하고 있다. 그러므로 발전 가능성이 있고 분명 흥미로운 분야임에 틀림없다. 필자 또한 한때 AI에 관심이 있어 얕은 지식으로나마 공부를 해본 사람으로서 오늘 deview에 나온 기술들이 결코 가벼운 결과물들이 아님을 알고 있다. 너무 좋은 경험이었고, 또 많은 것을 배웠고 겸손해지는 컨퍼런스였다.

'Forum > Conference' 카테고리의 다른 글

| [Conference] NAVER D2 Startup Factory 리뷰 (0) | 2019.11.17 |

|---|